автор:Владимир Овчинский

Елена Ларина

Июль 2023 года в США, Китае и России стал месяцем активного обсуждения проблем дальнейшего развития искусственного интеллекта.

Каковы шансы апокалипсиса с помощью ИИ?

10 июля 2023 года группа исследователей США, в которую вошли Эзра Каргер, экономист из Федерального резервного банка Чикаго, и Филип Тетлок, политолог из Пенсильванского университета, опубликовали в The Economist рабочий документ, в котором пытались пролить свет на этот вопрос путем систематического изучения мнений двух разного рода специалистов. С одной стороны, это предмет или «область», специалисты по ядерной войне, биологическому оружию, ИИ и вымиранию человечества. С другой находилась группа «суперпрогнозистов» — предсказателей общего назначения, которые делали точные прогнозы на самые разные темы, от результатов выборов до начала войн.

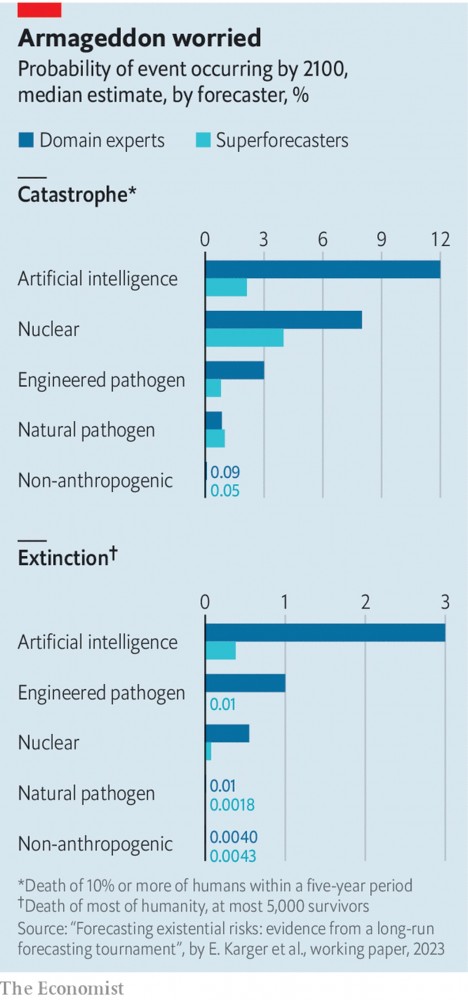

Исследователи наняли 89 суперпрогнозистов, 65 экспертов в предметной области и 15 экспертов по «риску исчезновения» в целом. Собравшимся было предложено рассмотреть два различных вида бедствий. «Катастрофа» определялась как событие, в результате которого погибло всего 10% людей в мире, или около 800 миллионов человек. (Для сравнения, Вторая мировая война, по оценкам, унесла жизни около 3% двухмиллиардного населения мира в то время.) «Вымирание» определялось как событие, которое уничтожило всех, за исключением, возможно, большинство, 5000 удачливых (или невезучих) душ.

Обеим группам было предложено оценить вероятность всего, начиная от неизбежных событий, таких как вымирание, вызванное ИИ, или ядерной войны, и заканчивая более мелкими вопросами, например , могут ли произойти тревожные достижения в возможностях ИИ, которые могли бы послужить указателями на будущую дорогу к грядущей катастрофе.

Самый поразительный вывод исследования заключался в том, что эксперты в предметной области, которые, как правило, доминируют в публичных разговорах об экзистенциальных рисках, кажутся более мрачными в отношении будущего, чем суперпрогнозисты. Эксперты подсчитали, что к 2100 году вероятность катастрофы составляет около 20%, а вероятность исчезновения — 6%. Суперпрогнозисты дали этим событиям вероятности в 9% и 1% каждое.

Этот широкий разрыв скрывал некоторые интересные детали. Разница между двумя группами была наибольшей при рассмотрении рисков, связанных с ИИ.

Средний суперпрогнозист подсчитал, что вероятность катастрофы, вызванной ИИ, составляет 2,1% , а вероятность вымирания, вызванного ИИ, к концу века составляет 0,38%.

Эксперты по искусственному интеллекту , напротив, присвоили этим двум событиям вероятность 12% и 3% соответственно. Когда дело дошло до пандемий, суперпрогнозисты были более пессимистичны, чем эксперты в предметной области, в отношении рисков, связанных с естественным заболеванием.

Возможно, самым интересным результатом было то, что, хотя группы разошлись во мнениях относительно точного размера риска, обе группы назвали ИИ самым большим беспокойством, независимо от того, думали ли они о катастрофе или вымирании (см. Диаграмму).

По словам Дэна Мейланда, суперпрогнозиста, участвовавшего в исследовании, одной из причин сильных результатов ИИ является то, что он действует как «множитель силы» в отношении других рисков, таких как ядерное оружие. Как и в случае с ядерной войной или ударом астероида, ИИ (скажем, в виде вооруженных роботов) может напрямую убивать людей. Но он также «мог служить для заточки топора другого палача», так сказать. Если бы люди использовали ИИ, например, для разработки более мощного биологического оружия, это внесло бы существенный вклад, хотя и косвенно, в любую последующую катастрофу.

Но хотя суперпрогнозисты относились к ИИ пессимистично, они также относились к нему относительно неуверенно. Мир жил с ядерным оружием почти 80 лет. Тот факт, что ядерной войны еще не было, представляет собой ценные данные, которые можно использовать для прогнозирования того, может ли она произойти в будущем.

ИИ в нынешнем значении этого термина, намного новее. Появление современных мощных моделей машинного обучения относится к началу 2010-х годов. И область все еще быстро развивается. Это оставляет гораздо меньше исторических данных, на которых можно основывать прогнозы.

Суперпрогнозисты и эксперты по ИИ придерживались совершенно разных взглядов на то, как общества могут отреагировать на небольшой ущерб, причиненный ИИ. Суперпрогнозисты склонны думать, что такой ущерб вызовет тщательное изучение и регулирование, чтобы предотвратить более серьезные проблемы позже. Эксперты в предметной области, напротив, склонны думать, что коммерческие и геополитические стимулы могут перевесить опасения по поводу безопасности, даже после того, как был нанесен реальный ущерб.

ИИ в США

Байден погрузился в искусственный интеллект

21 июля 2023 года Президент США Байден встретился с семью ведущими компаниями, занимающихся искусственным интеллектом (Amazon, Google и Meta* и др.), которые взяли на себя добровольные обязательства по управлению рисками, связанными с новой технологией.

Эти семь компаний согласились на добровольные обязательства по ответственным инновациям. Эти обязательства, которые компании будут выполнять немедленно, подчеркивают три фундаментальных принципа: безопасность, безопасность и доверие.

Во-первых, компании обязаны убедиться, что их технология безопасна, прежде чем выпустить ее для широкой публики. Это означает тестирование возможностей их систем, оценку их потенциального риска и обнародование результатов этих оценок.

Во-вторых, компании должны уделять первоочередное внимание безопасности своих систем, защищая свои модели от киберугроз и управляя рисками для национальной безопасности США, а также обмениваясь передовым опытом и необходимыми отраслевыми стандартами.

В-третьих, компании обязаны завоевать доверие людей и предоставить пользователям возможность принимать обоснованные решения.

Маркировка контента, который был изменен или создан искусственным интеллектом. Искоренение предрассудков и дискриминации, усиление защиты конфиденциальности и защита детей от вреда.

Добровольные гарантии — это лишь ранний предварительный шаг, поскольку Вашингтон и правительства всего мира спешат создать правовые и нормативные рамки для развития искусственного интеллекта. Соглашения включают в себя тестирование продуктов на наличие угроз безопасности и использование водяных знаков, чтобы потребители могли распознавать материалы, созданные искусственным интеллектом.

Объявление, сделанное 21 июля, отражает стремление администрации Байдена и законодателей срочно отреагировать на быстро развивающиеся технологии, даже несмотря на то, что законодатели изо всех сил пытаются регулировать социальные сети и другие технологии.

«В ближайшие недели я продолжу предпринимать исполнительные действия, чтобы помочь Америке проложить путь к ответственным инновациям», — сказал Байден. «И мы собираемся работать с обеими сторонами над разработкой соответствующего законодательства и правил».

Белый дом не сообщил подробностей о предстоящем указе президента, который будет касаться более серьезной проблемы: как контролировать способность Китая и других конкурентов завладеть новыми программами искусственного интеллекта или компонентами, используемыми для их разработки.

Это включает в себя новые ограничения на продвинутые полупроводники и ограничения на экспорт больших языковых моделей. Их трудно контролировать — большая часть программного обеспечения может поместиться в сжатом виде на флэш-накопителе.

Распоряжение может вызвать большее сопротивление со стороны отрасли, чем добровольные обязательства, озвученные 21 июля. Они, по словам экспертов, уже нашли отражение в практике вовлеченных компаний. Обещания не будут ограничивать планы компаний, занимающихся искусственным интеллектом, и не мешать развитию их технологий. И как добровольные обязательства, они не будут обеспечиваться государственными регулирующими органами.

«Мы рады взять на себя эти добровольные обязательства вместе с другими в этом секторе», — заявил Ник Клегг, президент по глобальным связям в Meta, материнской компании Facebook*. «Они являются важным первым шагом в обеспечении ответственных ограничений для ИИ и создают модель, которой должны следовать другие правительства».

Читать продолжение – ссылка